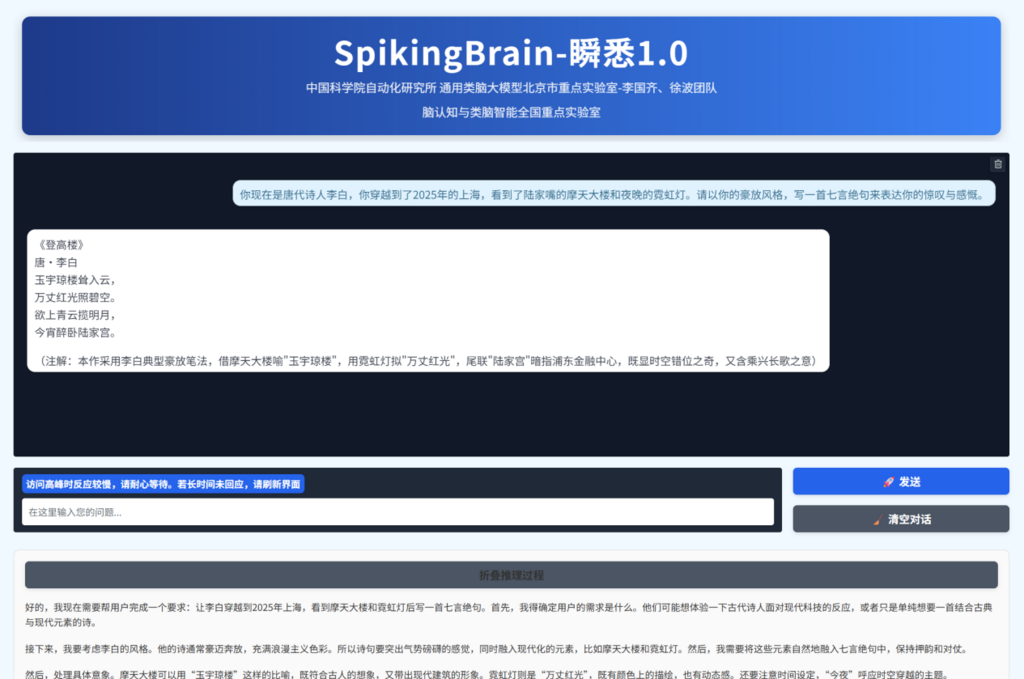

記者今天(9月8日)從中國科學院自動化研究所獲悉,近日,該研究所李國齊、徐波團隊與相關單位合作,成功研發出類腦脈衝大模型“瞬悉1.0”(SpikingBrain-1.0)。

該模型基於團隊原創的“內生複雜性”理論構建,在國產GPU平台上完成了全流程訓練與推理,顯著提升了大模型高效處理極長文本或數據序列的效率和速度,展示了構建國產自主可控的新型(非Transformer)大模型架構生態的可行性。

當前主流的Transformer模型,在處理超長文章或對話時速度會非常慢且成本極高,造成了巨大的資源消耗。可以說,當前大模型的飛速發展,背後是由巨大的資源消耗驅動的。因此,亟須發展一條低功耗高效率的新型大模型路線。

與當前主流大模型架構(Transformer架構)不同,“瞬悉1.0”借鑑大腦神經元內部工作機制,清晰地展示了一條不斷提升模型複雜度和性能的新型可行路徑。該模型僅需約主流模型2%的數據量,就能在多項語言理解和推理任務中達到媲美衆多主流模型的性能。

這是我國首次提出大規模類腦線性基礎模型架構,並首次在國產GPU算力集群上構建類腦脈衝大模型的訓練和推理框架。其超長序列處理能力在法律與醫學文檔分析、複雜多智能體模擬、高能粒子物理實驗、DNA序列分析、分子動力學軌跡等超長序列任務建模場景中具有顯著的潛在效率優勢。本次發佈的大模型為新一代人工智能發展提供了非Transformer架構的新技術路線,並將啓迪更低功耗的下一代神經形態計算理論和芯片設計。

今日熱搜

今日熱搜

本週熱搜

本週熱搜

本月熱搜

本月熱搜

查看更多

查看更多